お知らせ:当社は、お客様により充実したサポート情報を迅速に提供するため、本ページのコンテンツは機械翻訳を用いて日本語に翻訳しています。正確かつ最新のサポート情報をご覧いただくには、本内容の

英語版を参照してください。

インクリメンタルデータフェッチは、新規または更新済みファイルをデータ元からインポートする際に使用される方法です。Zoho DataPrep では、Zoho Databridge を利用してローカルファイルからインクリメンタルデータをインポートできます。

DataPrep では、CSV、TSV、JSON、XML、TXT など、さまざまなファイル形式をインクリメンタルにインポートできます。

メモ :

1. DataPrep では、拡張子のないファイルやプレーンテキスト形式のファイルにも対応しています。ただし、バイナリファイルはインポート時に解析できません。ユーザーは、上記の対応形式のいずれかに手動で変換する必要があります。

2. インポート時に対応するローカルファイルの最大サイズは 100MB です。その他の詳細については、こちらの技術的制限をご覧ください。

インポートを開始するには

1. 既存のpipelineを開くか、パイプラインを作成します。「ホーム」ページ、「Pipelines」タブ、または「Workspaces」タブから「追加するdata」オプションをクリックします。

ヒント:パイプラインビルダーの上部にある「インポートするdata」

ヒント:パイプラインビルダーの上部にある「インポートするdata」 アイコンをクリックして、複数のソースからパイプラインにデータを取り込むこともできます。

アイコンをクリックして、複数のソースからパイプラインにデータを取り込むこともできます。

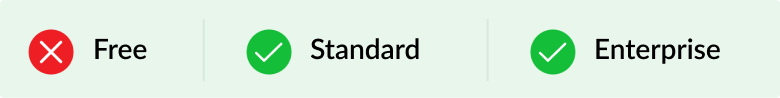

2. Filesオプションを選択する your data データ元から選択し、ローカルファイルをインポートします。また、左側のペインからFilesカテゴリーをクリックし、Filesオプションを選択することもできます。

インポートする incremental data

3. ローカルネットワークからインポートトグルを有効にし、ローカルファイルを増分でインポートします。

情報: ローカルファイルをインポートするには、マシンにZoho Databridgeをインストールしていることをご確認ください。

こちらをクリックして、Zoho Databridgeのダウンロードおよびインストール方法をご覧いただけます。

4. 有効なDatabridgeを選択し、以下の詳細を入力します。

フォルダーパス: ファイルを検索するフォルダーのパスを指定します。例:D:\DataPrep\Datasets

情報: フォルダーパスは大文字と小文字が区別されます。

含める subfolders: ファイル検索時にsubfoldersも含めたい場合は、このチェックボックスを選択してください。

File pattern: 指定した場所内のファイル名を照合するために使用するパターンです。正規表現タイプのマッチングに対応しています。また、パターン「.*」を使用すると、指定したパス内のすべてのファイルを照合できます。

情報: File patternは大文字と小文字を区別します。

メモ:ファイルパターン「照合する」はシンプルな正規表現の種類「照合する」です。例えば、Sales_2022.csv,Sales_2023.csv, Sales_2024.csvといったファイル名を取得する場合は、パターンとしてSales_.* を入力します。

同様に、PublicData1.csv , PublicData2.csv , PublicData3.csvなどのファイルを取得する場合は、公開する.*

1つのファイルのみをインポートする場合は、正確なファイル名を使ってパターンを指定してください。

例:leads_jan_2022.*

ファイルパスワード:ファイルがパスワード保護されている場合は、パスワードを入力してください。

ファイルをマージしてインポートする- 指定されたパターンに照合するすべてのファイルをマージし、1つのデータセットとしてインポートします。

情報: このオプションでは、一度に最大5つのファイルのみをマージできます。

メモ: このチェックボックスがオフの場合、1回の操作で取得済みとなるファイルは1つだけです。

メモ: このチェックボックスがオフの場合、1回の操作で取得済みとなるファイルは1つだけです。

例:ローカルパスにファイルが10個ある場合、最初の5つが1つのデータセットにマージされてインポートされます。次回の更新時に、残りの5つがマージされてインポートされます。

同様に、ローカルパスにファイルが8個ある場合、最初の5つが先にマージ・取得済みとなり、その後、残りの3つが対象となります。

ファイルの種類: 必須のファイル形式を選択してください。利用可能なフォーマットはCSV、TSV、JSON、XLS、XLSX、XML、TXTです。

シートパターン: このオプションはXLSおよびXLSX形式でのみ利用可能です。 ファイル内のシート名を照合するために使用するパターンです。正規表現形式でのマッチングに対応しています。任意のシートにマッチさせたい場合はパターン「.*」も使用できます。

シートパターンの照合するは、シンプルな正規表現ベースの照合するでもあります。例えば、Sales_2022、Sales_2023、Sales_2024といった名前の表計算シートを取得したい場合は、パターンとしてSales_.*と入力します。

同様に、PublicData1、PublicData2、PublicData3などの表計算シートを取得する場合は、公開する.*を使用します。

1つのシートのみインポートする場合は、正確なシート名をパターンに指定してください。

例:Leads_Jan_2022.*

情報: シートパターンは大文字と小文字を区別します。

Sheet パスワード:このオプションはXLSおよびXLSX形式のみ利用可能です。シートがパスワード保護されている場合は、パスワードを入力してください。

Merge 表計算シート and インポートする:指定したパターンに照合するすべての表計算シートを統合し、1つのデータセットとしてインポートします。

このオプションを利用すると、インポート時に表計算シートを統合でき、インポート後にユニオン処理を行う必要がありません。

メモ: このチェックボックスがオフの場合、1度に取得できるシートは1つのみとなります。

メモ: このチェックボックスがオフの場合、1度に取得できるシートは1つのみとなります。

5. インポートするボタンをクリックします。データのインポートが完了すると、Visual Pipeline builderが開き、変換の適用を開始できます。また、ステージを右クリックしてPrepare dataオプションを選択し、DataPrep Studioページでデータの準備を行うことも可能です。変換について詳しくはこちらをクリックしてください。

6. データフローの作成と各ステージで必要な変換の適用が完了した後、ステージを右クリックして保存先を追加して、データフローを完了できます。

7. パイプラインに宛先を追加した後は、まず手動実行でパイプラインを実行してみてください。手動実行が正常に動作することを確認した後、自動化のためのスケジュールを設定できます。各種実行タイプの詳細についてはこちらをご参照ください。

スケジュール、バックフィル、手動更新、Webhook、Zoho Flowを設定する際には、すべてのソースに対してインポート設定を必ず行う必要があります。インポート設定を行っていない場合は、実行を保存できません。こちらをクリックしてインポート設定方法の詳細をご確認ください。

8. 実行を設定した後、指定した実行時間にパイプラインジョブが作成されます。ジョブのステータスは、ジョブ概要で詳細に確認できます。こちらをクリックしてジョブ概要の詳細をご確認ください。

Databridgeを使用しないローカルファイルのインポート設定

Zoho Databridgeを使ってローカルファイルからデータをインポートできます。インポート設定については以下のセクションをご参照ください。

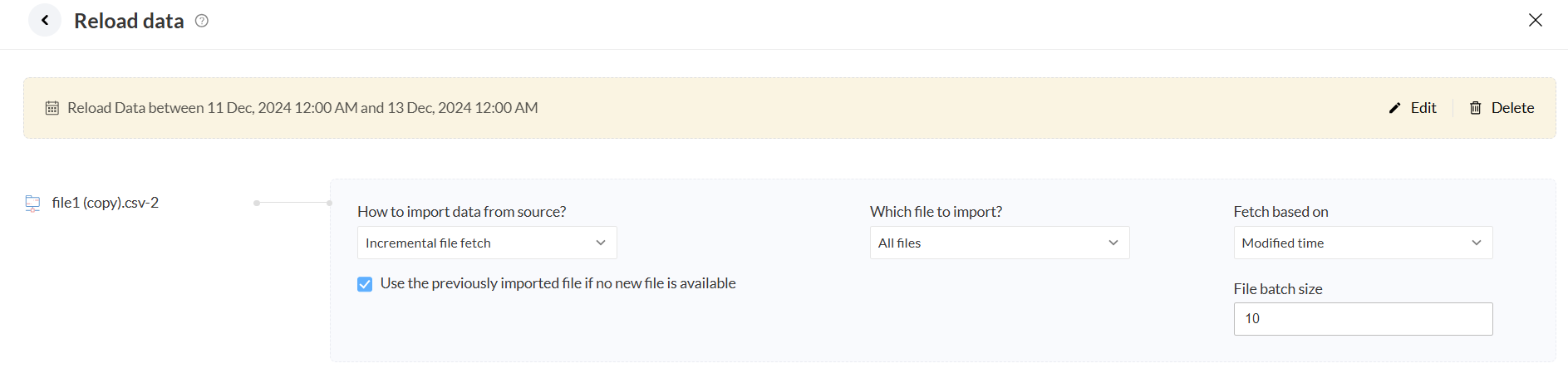

バックフィル実行および手動更新を設定する際は、すべてのソースに対して必ずインポート設定を行う必要があります。インポート設定がされていない場合、実行は保存できません。

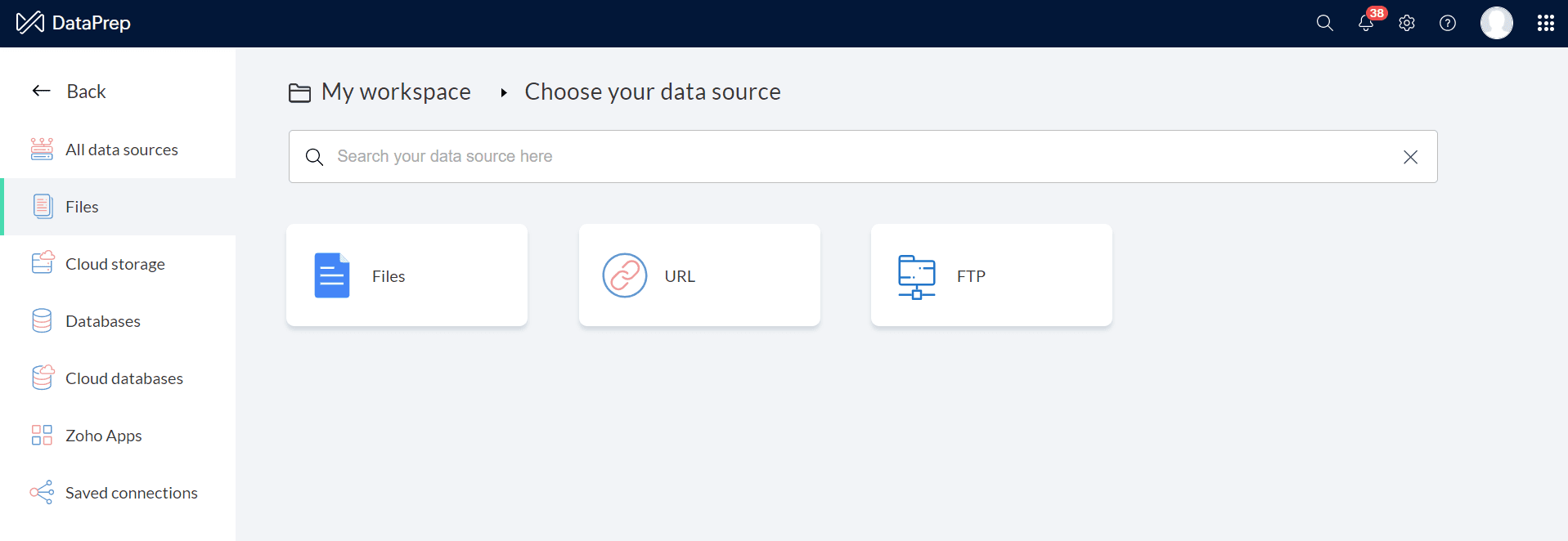

以下はバックフィル設定画面のスナップショットです。

データ元からデータをインポートする方法データ元ファイルを選択してインポートするか、データをインポートしないオプションを使用できます。

データ元ファイルをインポートする

このオプションを選択すると、頻度実行時にデータ元ファイルがインポートされます。

メモ: インポート設定は、スケジュール、Webhook、Zoho Flowのデータ元がファイルの場合、適用対象とは異なります。ただし、Backfillや手動更新の場合は、ファイルアップロード

メモ: インポート設定は、スケジュール、Webhook、Zoho Flowのデータ元がファイルの場合、適用対象とは異なります。ただし、Backfillや手動更新の場合は、ファイルアップロード

オプションがインポート設定時に利用できます。「ファイルの解析方法」オプションを使用すると、不明なファイル形式も解析可能です。

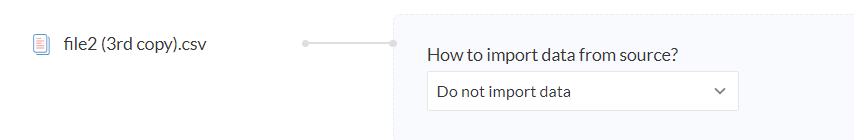

データをインポートしない

データは1回のみインポートされます。2回目以降は同じデータに対してルールが適用され、エクスポートされます。

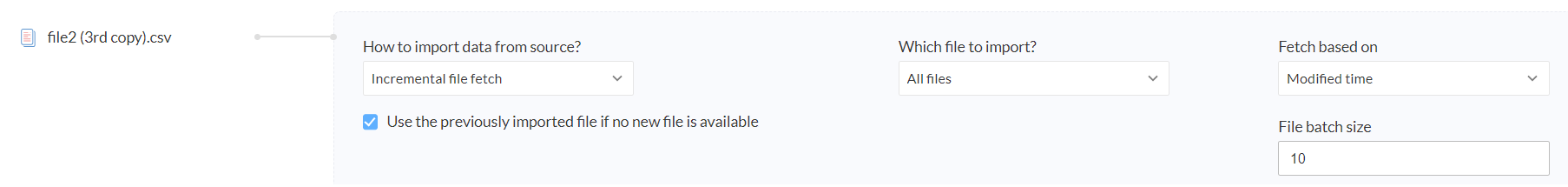

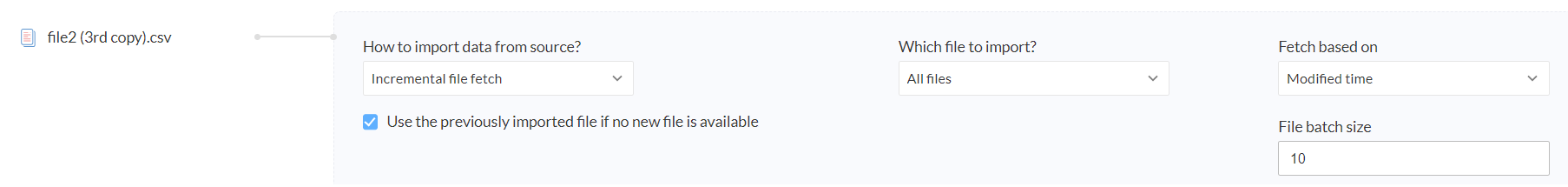

Databridge を使用したローカルファイルのインポート設定

ローカルネットワークからデータをインポートする場合は、以下のインポート設定により、ローカルネットワークからのデータのインポート方法や増分データの取得方法を設定できます。

「こちらをクリック」リンクを選択して、インポート設定を行えます。

下記はバックフィル設定画面のスナップショットです。

データ元からデータをインポートする方法

ドロップダウンから、データのインポート方法を選択します - すべてのデータをインポート、増分ファイル取得、データをインポートしないから選択できます。

すべてのデータをインポート

このオプションを選択すると、ファイルパターンに一致するすべての利用可能なデータがインポートされます。

File バッチサイズ: すべてのファイルをインポートする際に、バッチサイズを指定します。ファイルは、最初の更新済み時間に基づき、この数でグループ化されます。これらのファイルは1つのファイルとしてインポートされ、指定された頻度で宛先にエクスポートされます。

情報: File バッチサイズは10を超えることはできません。このオプションは、ローカルネットワークからデータをインポートする場合のみ利用可能です。

インクリメンタルファイル取得

ローカルネットワークからインクリメンタルデータをインポート・取得する方法を設定できます。 インポートする設定 オプションを使用します。インクリメンタルデータインポートは、新規または更新済みデータを前回のデータ取得間隔以降にインポートする方法です。

新規データが利用できない場合は、以前にインポートしたデータを使用:

- チェックボックスがオンの場合:データ元に新規データがない場合、最後に取得したデータが再度インポートされます。

- チェックボックスがオフの場合:データ元に新規データがない場合、インポートは失敗し、ファイルはインポートされません。その結果、パイプラインジョブ全体が失敗します。

どのファイルをインポートするか?インポートするファイルとして すべてのファイル、最新ファイル、または最古ファイルをこのオプションで選択できます。

すべてのファイル

このオプションを選択すると、指定したファイルパターンに一致するファイルが、指定したデータ区間内でのみインポートされます(Fetch based オン項目に基づきます)。

Fetch based オン: ファイルの並び替えとインポートの基準となる時間を選択できます - 更新済み時間

ファイルバッチサイズ: すべてのファイルを段階的にインポートする場合のバッチサイズを指定します。ファイルはこの数値ごとに、指定したデータ区間内の更新済み時間に基づいてグループ化されます。グループ化されたファイルは1つのファイルとしてインポートされ、エクスポート済みとして所定の頻度で出力されます。

情報: ファイルバッチサイズは10を超えることはできません。このオプションはローカルネットワークからデータをインポートする場合のみ利用可能です。

情報: ファイルバッチサイズは10を超えることはできません。このオプションはローカルネットワークからデータをインポートする場合のみ利用可能です。

最新ファイル

このオプションを選択すると、指定したファイルパターンに一致する最新のファイルが、指定したデータ区間内でインポートされます(Fetch based オン項目に基づきます)。

最も古いファイル

このオプションを選択すると、指定したファイルパターンに一致し、特定のデータ間隔内で最も古いファイルが、Fetch based オン項目に基づいてインポートされます。

データをインポートしない

データは一度だけインポートされます。2回目以降は、ルールが同じデータに適用され、取得済みとしてエクスポートされます。

増分同期の仕組み

データ元から増分データをどのようにインポートし取得するかを、インポートする設定オプションで設定できます。増分データのインポートは、特定のデータ間隔内で新規または更新済みデータをインポートする方法です。

増分ファイルフェッチでは、パイプライン実行時に新規または更新済みファイルが取得されます。頻度データ間隔中は、直前のデータ間隔以降に作成または更新されたファイルがインポートされます。ローカルファイルパスに新規ファイルがない場合、データはインポートされず、または以前インポートされたデータがインポート設定に従い再び取得されます。次のデータ間隔では、その間隔内で作成または更新されたファイルが取得されます。

スケジュール実行時のインクリメンタル取得

インクリメンタルファイル取得では、パイプラインがスケジュールされると、最初のスケジュールのデータ区間は前へから現在までの範囲になります。この区間内で、新規または更新済みファイルがすべて取得されます。2回目のスケジュールでは、現在から次の区間へと延長され、それ以降も同様のパターンで進行します。

例えば、スケジュールが1時間間隔に設定されている場合、データ元には合計10ファイルがあり、そのうち5ファイルが1時間前にファイルパターンに照合してアップロードされました。インポートする設定はすべてのファイルをインクリメンタルにインポートするようになっており、バッチサイズは10に設定されています。

最初のスケジュール実行時には、直近1時間以内に作成または更新済みの5ファイルが取得され、1つのファイルとしてエクスポートされます。

2回目のスケジュールでは、データ元に同じファイルパターンで新規ファイルが4つ追加された場合、その4ファイルのみが、その区間内の作成または更新時間に基づいて取得・エクスポートされます。

3回目のスケジュールで、ファイルパターンに照合する新規ファイルが13件データ元に追加された場合、バッチサイズが10に設定されているため、最初の10ファイルのみがデータ元の作成または更新時間に基づいて取得・エクスポートされます。同様のロジックが、今後のスケジュールにおけるインクリメンタル取得にも適用されます。

こちらをクリックして、スケジュール実行についてご確認ください。

バックフィル実行時のインクリメンタル取得

インクリメンタルファイル取得では、パイプラインにバックフィル実行が設定されている場合、指定したデータ区間内のすべてのインクリメンタルファイルが取得されます。

例えば、バックフィルが8月1日から3日まで毎日ジョブで設定されている場合、8月1日は4件、8月2日は7件、8月3日は13件のファイルがあります。インポートする設定は、すべてのファイルをインクリメンタル方式で、バッチサイズ10で取得するようになっています。

最初のバックフィルジョブでは、8月1日に作成または更新済みの4ファイルが取得・エクスポートされ、1つのファイルとしてまとめられます。2回目のバックフィルジョブでは、8月2日の7ファイルも同様に処理・エクスポートされます。3回目のバックフィルジョブでは、8月3日の最初の10ファイルが取得・エクスポートされ、1つのファイルとしてまとめられます。

バックフィル実行についてはこちらをクリック

更新データのインクリメンタル取得

インクリメンタルファイル取得では、パイプラインに更新するが設定されている場合、指定したデータ期間内のすべての新規または更新済みファイルが取得されます。

例えば、更新するが8月1日から2日の間で設定されています。

8月1日は3件、8月2日は4件のファイルがあります。インポートする設定は、すべてのファイルをインクリメンタル方式で、バッチサイズ5、最も古い更新済み時間に基づいて取得します。

更新するジョブでは、8月1日に作成された3ファイルと、8月2日に作成された最初の2ファイルが取得およびエクスポートされ、1つのファイルにまとめられます。

更新についてはこちらをクリック

関連情報

FTPサーバーからデータを増分インポートする方法

ヒント:パイプラインビルダーの上部にある「インポートするdata」

ヒント:パイプラインビルダーの上部にある「インポートするdata」

メモ: このチェックボックスがオフの場合、1回の操作で取得済みとなるファイルは1つだけです。

メモ: このチェックボックスがオフの場合、1回の操作で取得済みとなるファイルは1つだけです。

メモ: このチェックボックスがオフの場合、1度に取得できるシートは1つのみとなります。

メモ: このチェックボックスがオフの場合、1度に取得できるシートは1つのみとなります。

メモ: インポート設定は、スケジュール、Webhook、Zoho Flowのデータ元がファイルの場合、適用対象とは異なります。ただし、Backfillや手動更新の場合は、ファイルアップロード

メモ: インポート設定は、スケジュール、Webhook、Zoho Flowのデータ元がファイルの場合、適用対象とは異なります。ただし、Backfillや手動更新の場合は、ファイルアップロード

情報: ファイルバッチサイズは10を超えることはできません。このオプションはローカルネットワークからデータをインポートする場合のみ利用可能です。

情報: ファイルバッチサイズは10を超えることはできません。このオプションはローカルネットワークからデータをインポートする場合のみ利用可能です。